26 KiB

English | 简体中文 | 繁體中文 | 한국어 | Español | 日本語 | हिन्दी | Русский | Рortuguês | తెలుగు | Français | Deutsch | Tiếng việt |

Công nghệ Học máy tiên tiến cho JAX, PyTorch và TensorFlow

🤗 Transformers cung cấp hàng ngàn mô hình được huấn luyện trước để thực hiện các nhiệm vụ trên các modalities khác nhau như văn bản, hình ảnh và âm thanh.

Các mô hình này có thể được áp dụng vào:

- 📝 Văn bản, cho các nhiệm vụ như phân loại văn bản, trích xuất thông tin, trả lời câu hỏi, tóm tắt, dịch thuật và sinh văn bản, trong hơn 100 ngôn ngữ.

- 🖼️ Hình ảnh, cho các nhiệm vụ như phân loại hình ảnh, nhận diện đối tượng và phân đoạn.

- 🗣️ Âm thanh, cho các nhiệm vụ như nhận dạng giọng nói và phân loại âm thanh.

Các mô hình Transformer cũng có thể thực hiện các nhiệm vụ trên nhiều modalities kết hợp, như trả lời câu hỏi về bảng, nhận dạng ký tự quang học, trích xuất thông tin từ tài liệu quét, phân loại video và trả lời câu hỏi hình ảnh.

🤗 Transformers cung cấp các API để tải xuống và sử dụng nhanh chóng các mô hình được huấn luyện trước đó trên văn bản cụ thể, điều chỉnh chúng trên tập dữ liệu của riêng bạn và sau đó chia sẻ chúng với cộng đồng trên model hub của chúng tôi. Đồng thời, mỗi module python xác định một kiến trúc là hoàn toàn độc lập và có thể được sửa đổi để cho phép thực hiện nhanh các thí nghiệm nghiên cứu.

🤗 Transformers được hỗ trợ bởi ba thư viện học sâu phổ biến nhất — Jax, PyTorch và TensorFlow — với tích hợp mượt mà giữa chúng. Việc huấn luyện mô hình của bạn với một thư viện trước khi tải chúng để sử dụng trong suy luận với thư viện khác là rất dễ dàng.

Các demo trực tuyến

Bạn có thể kiểm tra hầu hết các mô hình của chúng tôi trực tiếp trên trang của chúng từ model hub. Chúng tôi cũng cung cấp dịch vụ lưu trữ mô hình riêng tư, phiên bản và API suy luận cho các mô hình công khai và riêng tư.

Dưới đây là một số ví dụ:

Trong Xử lý Ngôn ngữ Tự nhiên:

- Hoàn thành từ vụng về từ với BERT

- Nhận dạng thực thể đặt tên với Electra

- Tạo văn bản tự nhiên với Mistral

- Suy luận Ngôn ngữ Tự nhiên với RoBERTa

- Tóm tắt văn bản với BART

- Trả lời câu hỏi với DistilBERT

- Dịch văn bản với T5

Trong Thị giác Máy tính:

- Phân loại hình ảnh với ViT

- Phát hiện đối tượng với DETR

- Phân đoạn ngữ nghĩa với SegFormer

- Phân đoạn toàn diện với Mask2Former

- Ước lượng độ sâu với Depth Anything

- Phân loại video với VideoMAE

- Phân đoạn toàn cầu với OneFormer

Trong âm thanh:

- Nhận dạng giọng nói tự động với Whisper

- Phát hiện từ khóa với Wav2Vec2

- Phân loại âm thanh với Audio Spectrogram Transformer

Trong các nhiệm vụ đa phương thức:

- Trả lời câu hỏi về bảng với TAPAS

- Trả lời câu hỏi hình ảnh với ViLT

- Mô tả hình ảnh với LLaVa

- Phân loại hình ảnh không cần nhãn với SigLIP

- Trả lời câu hỏi văn bản tài liệu với LayoutLM

- Phân loại video không cần nhãn với X-CLIP

- Phát hiện đối tượng không cần nhãn với OWLv2

- Phân đoạn hình ảnh không cần nhãn với CLIPSeg

- Tạo mặt nạ tự động với SAM

100 dự án sử dụng Transformers

Transformers không chỉ là một bộ công cụ để sử dụng các mô hình được huấn luyện trước: đó là một cộng đồng các dự án xây dựng xung quanh nó và Hugging Face Hub. Chúng tôi muốn Transformers giúp các nhà phát triển, nhà nghiên cứu, sinh viên, giáo sư, kỹ sư và bất kỳ ai khác xây dựng những dự án mơ ước của họ.

Để kỷ niệm 100.000 sao của transformers, chúng tôi đã quyết định tập trung vào cộng đồng và tạo ra trang awesome-transformers liệt kê 100 dự án tuyệt vời được xây dựng xung quanh transformers.

Nếu bạn sở hữu hoặc sử dụng một dự án mà bạn tin rằng nên được thêm vào danh sách, vui lòng mở một PR để thêm nó!

Nếu bạn đang tìm kiếm hỗ trợ tùy chỉnh từ đội ngũ Hugging Face

Hành trình nhanh

Để ngay lập tức sử dụng một mô hình trên một đầu vào cụ thể (văn bản, hình ảnh, âm thanh, ...), chúng tôi cung cấp API pipeline. Pipelines nhóm một mô hình được huấn luyện trước với quá trình tiền xử lý đã được sử dụng trong quá trình huấn luyện của mô hình đó. Dưới đây là cách sử dụng nhanh một pipeline để phân loại văn bản tích cực so với tiêu cực:

>>> from transformers import pipeline

# Cấp phát một pipeline cho phân tích cảm xúc

>>> classifier = pipeline('sentiment-analysis')

>>> classifier('We are very happy to introduce pipeline to the transformers repository.')

[{'label': 'POSITIVE', 'score': 0.9996980428695679}]

Dòng code thứ hai tải xuống và lưu trữ bộ mô hình được huấn luyện được sử dụng bởi pipeline, trong khi dòng thứ ba đánh giá nó trên văn bản đã cho. Ở đây, câu trả lời là "tích cực" với độ tin cậy là 99,97%.

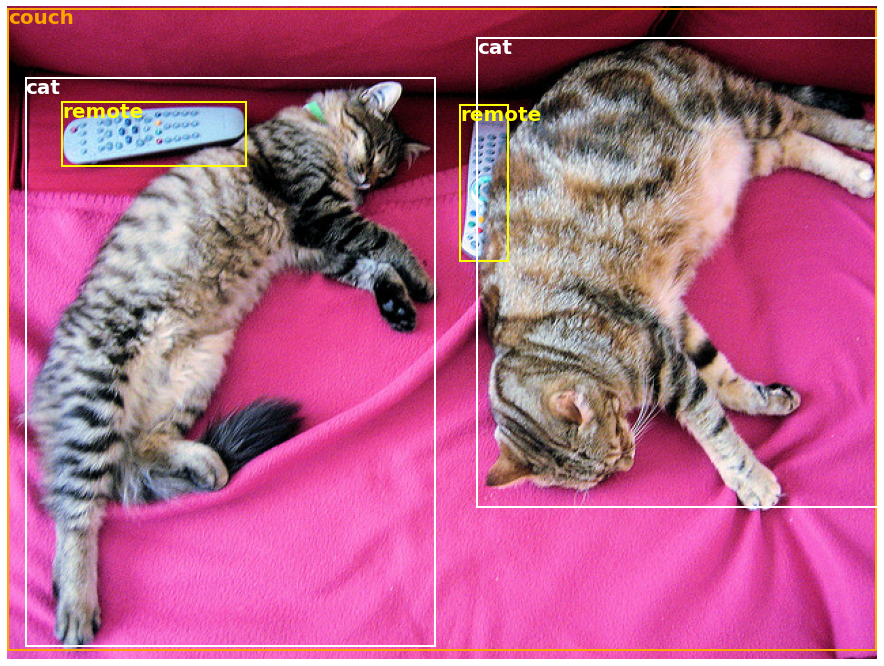

Nhiều nhiệm vụ có sẵn một pipeline được huấn luyện trước, trong NLP nhưng cũng trong thị giác máy tính và giọng nói. Ví dụ, chúng ta có thể dễ dàng trích xuất các đối tượng được phát hiện trong một hình ảnh:

>>> import requests

>>> from PIL import Image

>>> from transformers import pipeline

# Tải xuống một hình ảnh với những con mèo dễ thương

>>> url = "https://huggingface.co/datasets/huggingface/documentation-images/resolve/main/coco_sample.png"

>>> image_data = requests.get(url, stream=True).raw

>>> image = Image.open(image_data)

# Cấp phát một pipeline cho phát hiện đối tượng

>>> object_detector = pipeline('object-detection')

>>> object_detector(image)

[{'score': 0.9982201457023621,

'label': 'remote',

'box': {'xmin': 40, 'ymin': 70, 'xmax': 175, 'ymax': 117}},

{'score': 0.9960021376609802,

'label': 'remote',

'box': {'xmin': 333, 'ymin': 72, 'xmax': 368, 'ymax': 187}},

{'score': 0.9954745173454285,

'label': 'couch',

'box': {'xmin': 0, 'ymin': 1, 'xmax': 639, 'ymax': 473}},

{'score': 0.9988006353378296,

'label': 'cat',

'box': {'xmin': 13, 'ymin': 52, 'xmax': 314, 'ymax': 470}},

{'score': 0.9986783862113953,

'label': 'cat',

'box': {'xmin': 345, 'ymin': 23, 'xmax': 640, 'ymax': 368}}]

Ở đây, chúng ta nhận được một danh sách các đối tượng được phát hiện trong hình ảnh, với một hộp bao quanh đối tượng và một điểm đánh giá độ tin cậy. Đây là hình ảnh gốc ở bên trái, với các dự đoán hiển thị ở bên phải:

Bạn có thể tìm hiểu thêm về các nhiệm vụ được hỗ trợ bởi API pipeline trong hướng dẫn này.

Ngoài pipeline, để tải xuống và sử dụng bất kỳ mô hình được huấn luyện trước nào cho nhiệm vụ cụ thể của bạn, chỉ cần ba dòng code. Đây là phiên bản PyTorch:

>>> from transformers import AutoTokenizer, AutoModel

>>> tokenizer = AutoTokenizer.from_pretrained("google-bert/bert-base-uncased")

>>> model = AutoModel.from_pretrained("google-bert/bert-base-uncased")

>>> inputs = tokenizer("Hello world!", return_tensors="pt")

>>> outputs = model(**inputs)

Và đây là mã tương đương cho TensorFlow:

>>> from transformers import AutoTokenizer, TFAutoModel

>>> tokenizer = AutoTokenizer.from_pretrained("google-bert/bert-base-uncased")

>>> model = TFAutoModel.from_pretrained("google-bert/bert-base-uncased")

>>> inputs = tokenizer("Hello world!", return_tensors="tf")

>>> outputs = model(**inputs)

Tokenizer là thành phần chịu trách nhiệm cho việc tiền xử lý mà mô hình được huấn luyện trước mong đợi và có thể được gọi trực tiếp trên một chuỗi đơn (như trong các ví dụ trên) hoặc một danh sách. Nó sẽ xuất ra một từ điển mà bạn có thể sử dụng trong mã phụ thuộc hoặc đơn giản là truyền trực tiếp cho mô hình của bạn bằng cách sử dụng toán tử ** để giải nén đối số.

Chính mô hình là một Pytorch nn.Module thông thường hoặc một TensorFlow tf.keras.Model (tùy thuộc vào backend của bạn) mà bạn có thể sử dụng như bình thường. Hướng dẫn này giải thích cách tích hợp một mô hình như vậy vào một vòng lặp huấn luyện cổ điển PyTorch hoặc TensorFlow, hoặc cách sử dụng API Trainer của chúng tôi để tinh chỉnh nhanh chóng trên một bộ dữ liệu mới.

Tại sao tôi nên sử dụng transformers?

-

Các mô hình tiên tiến dễ sử dụng:

- Hiệu suất cao trong việc hiểu và tạo ra ngôn ngữ tự nhiên, thị giác máy tính và âm thanh.

- Ngưỡng vào thấp cho giảng viên và người thực hành.

- Ít trừu tượng dành cho người dùng với chỉ ba lớp học.

- Một API thống nhất để sử dụng tất cả các mô hình được huấn luyện trước của chúng tôi.

-

Giảm chi phí tính toán, làm giảm lượng khí thải carbon:

- Các nhà nghiên cứu có thể chia sẻ các mô hình đã được huấn luyện thay vì luôn luôn huấn luyện lại.

- Người thực hành có thể giảm thời gian tính toán và chi phí sản xuất.

- Hàng chục kiến trúc với hơn 400.000 mô hình được huấn luyện trước trên tất cả các phương pháp.

-

Lựa chọn framework phù hợp cho mọi giai đoạn của mô hình:

- Huấn luyện các mô hình tiên tiến chỉ trong 3 dòng code.

- Di chuyển một mô hình duy nhất giữa các framework TF2.0/PyTorch/JAX theo ý muốn.

- Dễ dàng chọn framework phù hợp cho huấn luyện, đánh giá và sản xuất.

-

Dễ dàng tùy chỉnh một mô hình hoặc một ví dụ theo nhu cầu của bạn:

- Chúng tôi cung cấp các ví dụ cho mỗi kiến trúc để tái tạo kết quả được công bố bởi các tác giả gốc.

- Các thành phần nội tại của mô hình được tiết lộ một cách nhất quán nhất có thể.

- Các tệp mô hình có thể được sử dụng độc lập với thư viện để thực hiện các thử nghiệm nhanh chóng.

Tại sao tôi không nên sử dụng transformers?

- Thư viện này không phải là một bộ công cụ modul cho các khối xây dựng mạng neural. Mã trong các tệp mô hình không được tái cấu trúc với các trừu tượng bổ sung một cách cố ý, để các nhà nghiên cứu có thể lặp nhanh trên từng mô hình mà không cần đào sâu vào các trừu tượng/tệp bổ sung.

- API huấn luyện không được thiết kế để hoạt động trên bất kỳ mô hình nào, mà được tối ưu hóa để hoạt động với các mô hình được cung cấp bởi thư viện. Đối với vòng lặp học máy chung, bạn nên sử dụng một thư viện khác (có thể là Accelerate).

- Mặc dù chúng tôi cố gắng trình bày càng nhiều trường hợp sử dụng càng tốt, nhưng các tập lệnh trong thư mục examples chỉ là ví dụ. Dự kiến rằng chúng sẽ không hoạt động ngay tức khắc trên vấn đề cụ thể của bạn và bạn sẽ phải thay đổi một số dòng mã để thích nghi với nhu cầu của bạn.

Cài đặt

Sử dụng pip

Thư viện này được kiểm tra trên Python 3.8+, Flax 0.4.1+, PyTorch 1.11+ và TensorFlow 2.6+.

Bạn nên cài đặt 🤗 Transformers trong một môi trường ảo Python. Nếu bạn chưa quen với môi trường ảo Python, hãy xem hướng dẫn sử dụng.

Trước tiên, tạo một môi trường ảo với phiên bản Python bạn sẽ sử dụng và kích hoạt nó.

Sau đó, bạn sẽ cần cài đặt ít nhất một trong số các framework Flax, PyTorch hoặc TensorFlow. Vui lòng tham khảo trang cài đặt TensorFlow, trang cài đặt PyTorch và/hoặc Flax và Jax để biết lệnh cài đặt cụ thể cho nền tảng của bạn.

Khi đã cài đặt một trong các backend đó, 🤗 Transformers có thể được cài đặt bằng pip như sau:

pip install transformers

Nếu bạn muốn thực hiện các ví dụ hoặc cần phiên bản mới nhất của mã và không thể chờ đợi cho một phiên bản mới, bạn phải cài đặt thư viện từ nguồn.

Với conda

🤗 Transformers có thể được cài đặt bằng conda như sau:

conda install conda-forge::transformers

GHI CHÚ: Cài đặt

transformerstừ kênhhuggingfaceđã bị lỗi thời.

Hãy làm theo trang cài đặt của Flax, PyTorch hoặc TensorFlow để xem cách cài đặt chúng bằng conda.

GHI CHÚ: Trên Windows, bạn có thể được yêu cầu kích hoạt Chế độ phát triển để tận dụng việc lưu cache. Nếu điều này không phải là một lựa chọn cho bạn, hãy cho chúng tôi biết trong vấn đề này.

Kiến trúc mô hình

Tất cả các điểm kiểm tra mô hình được cung cấp bởi 🤗 Transformers được tích hợp một cách mượt mà từ trung tâm mô hình huggingface.co model hub, nơi chúng được tải lên trực tiếp bởi người dùng và tổ chức.

Số lượng điểm kiểm tra hiện tại:

🤗 Transformers hiện đang cung cấp các kiến trúc sau đây: xem ở đây để có một tóm tắt tổng quan về mỗi kiến trúc.

Để kiểm tra xem mỗi mô hình có một phiên bản thực hiện trong Flax, PyTorch hoặc TensorFlow, hoặc có một tokenizer liên quan được hỗ trợ bởi thư viện 🤗 Tokenizers, vui lòng tham khảo bảng này.

Những phiên bản này đã được kiểm tra trên một số tập dữ liệu (xem các tập lệnh ví dụ) và nên tương đương với hiệu suất của các phiên bản gốc. Bạn có thể tìm thấy thêm thông tin về hiệu suất trong phần Ví dụ của tài liệu.

Tìm hiểu thêm

| Phần | Mô tả |

|---|---|

| Tài liệu | Toàn bộ tài liệu API và hướng dẫn |

| Tóm tắt nhiệm vụ | Các nhiệm vụ được hỗ trợ bởi 🤗 Transformers |

| Hướng dẫn tiền xử lý | Sử dụng lớp Tokenizer để chuẩn bị dữ liệu cho các mô hình |

| Huấn luyện và điều chỉnh | Sử dụng các mô hình được cung cấp bởi 🤗 Transformers trong vòng lặp huấn luyện PyTorch/TensorFlow và API Trainer |

| Hướng dẫn nhanh: Điều chỉnh/sử dụng các kịch bản | Các kịch bản ví dụ để điều chỉnh mô hình trên nhiều nhiệm vụ khác nhau |

| Chia sẻ và tải lên mô hình | Tải lên và chia sẻ các mô hình đã điều chỉnh của bạn với cộng đồng |

Trích dẫn

Bây giờ chúng ta có một bài báo mà bạn có thể trích dẫn cho thư viện 🤗 Transformers:

@inproceedings{wolf-etal-2020-transformers,

title = "Transformers: State-of-the-Art Natural Language Processing",

author = "Thomas Wolf and Lysandre Debut and Victor Sanh and Julien Chaumond and Clement Delangue and Anthony Moi and Pierric Cistac and Tim Rault and Rémi Louf and Morgan Funtowicz and Joe Davison and Sam Shleifer and Patrick von Platen and Clara Ma and Yacine Jernite and Julien Plu and Canwen Xu and Teven Le Scao and Sylvain Gugger and Mariama Drame and Quentin Lhoest and Alexander M. Rush",

booktitle = "Proceedings of the 2020 Conference on Empirical Methods in Natural Language Processing: System Demonstrations",

month = oct,

year = "2020",

address = "Online",

publisher = "Association for Computational Linguistics",

url = "https://www.aclweb.org/anthology/2020.emnlp-demos.6",

pages = "38--45"

}